NVIDIA的“GPU节”会罢了吗?german_sex5

自2022年11月30日好意思国Open AI发布ChatGPT以来,生成式AI(东谈主工智能)成为一大激越,NVIDIA的GPU当作AI半导体运转流行。干系词,在GPU的坐褥中,存在两个瓶颈:台积电的中制程和高带宽内存(HBM)与DRAM堆叠,导致GPU在大家范围内空泛“瓶颈是HBM和台积电之间的中间制程吗?”

在这些GPU中,“H100”的需求量尤其大,其价钱飙升至4万好意思元,激发了所谓的NVIDIA“GPU节”。

在这种情况下,台积电将中制程中介层产能翻倍,SK海力士等DRAM制造商增多了HBM产量,导致“H100”的交货技能从52周镌汰至20周。

那么,NVIDIA的“GPU节”会罢了吗?

因此,在这篇著作中,咱们将参议NVIDIA的“GPU节”是否行将罢了。先说论断,估量即使到2024年,ChatGPT级AI建树和运营所需的高端AI劳动器(界说将在背面讲明注解)也只须3.9%的出货量。因此,谷歌、亚马逊、微软等云劳动提供商(CSP)的需求似乎根柢无法得到稳定。总之,到面前为止,NVIDIA 的“GPU 节”还仅仅一个运转,全面的生成式 AI 激越行将到来。

底下,咱们先简便转头一下NVIDIA GPU的两大瓶颈。

两个NVIDIA GPU瓶颈

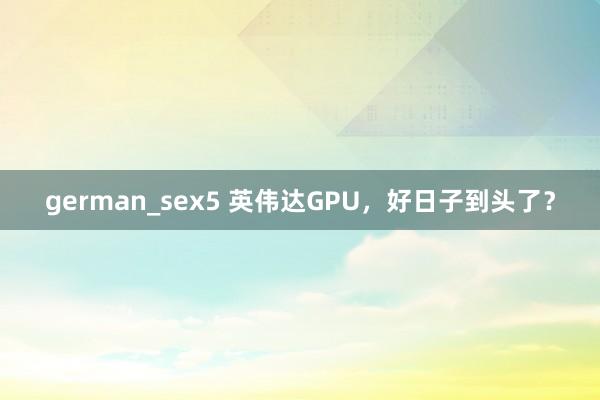

在NVIDIA GPU的坐褥中,代工场台积电崇敬通盘前、中、后工序。这里,中间工序是指分别坐褥GPU、CPU、HBM等芯片,并将其放手在从12英寸硅片切下的方形基板上的工序。这种基板称为硅中介层(图 1)。

图1 2.5D到3D中出现的中级工艺,举例NVIDIA GPU(辛勤着手:Tadashi Kamewada)

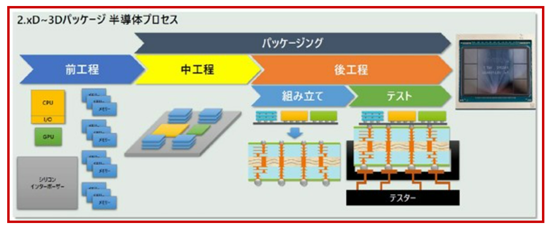

另外,台积电建树的NVIDIA GPU封装称为CoWoS(Chip on Wafer on Substrate),但两个瓶颈是硅中介层容量和HBM(图2)。情况如下。

图2 CoWoS结构和NVIDIA GPU上的两个瓶颈(着手:WikiChip)

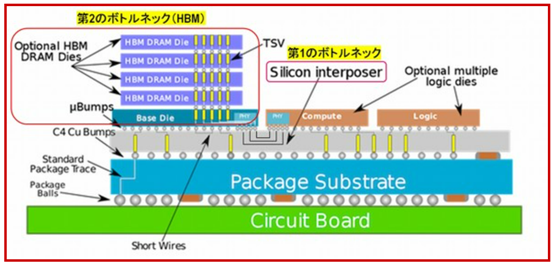

CoWoS 于 2011 年建树,但而后,跟着 GPU 性能的提升,GPU 芯片的尺寸不断增大,GPU 中装置的 HBM 数目也随之增多(图 3)。成果,硅中介层逐年变大,而从单个晶圆上可取得的中介层数目却与之成反比减少。

图3 Interposer面积和HBM数目跟着每一代的增多而增多(辛勤着手:KC Yee(TSMC))

此外,GPU中装置的HBM数目增多,HBM里面堆叠的DRAM芯片数目也增多。此外,DRAM每两年就会袖珍化一次,HBM步伐每两年更新一次以提升性能。因此,顶端HBM供不应求。

在这种情况下,台积电将其硅中介层产能从2023年夏日前后的每月15000片翻倍至本年夏日前后的每月最初30000片。此外,三星电子和好意思光科技已取得NVIDIA认证,并运转供应顶端HBM,此前由SK海力士主导。

受上述影响,需求量最高的NVIDIA H100的交货技能从52周大幅镌汰至20周。那么,AI劳动器的出货量因此增多了若干呢?

两类AI劳动器的界说

字据DIGITIMES Research发布的《大家年度劳动器出货量,2023-2024》(Servers Report Database, 2024)浮现,AI劳动器有两种类型:

配备两个或多个AI加快器但未配备HBM的系统称为“通用AI劳动器”。

配备至少四个搭载HBM的AI加快器的系统被称为“高端AI劳动器”。

这里的AI加快器是指为加快AI诓骗,特等是神经网罗和机器学习而设想的很是硬件,典型的例子即是NVIDIA的GPU。此外,ChatGPT级别的生成式AI的建树和运行需要无数高端AI劳动器,而不是通用AI劳动器。

那么,通用AI劳动器和高端AI劳动器的出货量分别是若干?

通用AI劳动器和高端AI劳动器出货量

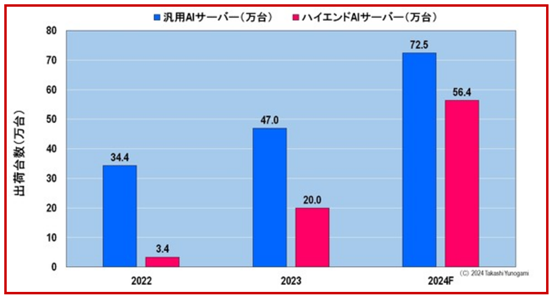

图4浮现了2022年至2023年通用AI劳动器和高端AI劳动器的出货量。估量2022年通用AI劳动器出货量为34.4万台,2023年出货量为47万台,2024年出货量为72.5万台。

图4 通用AI劳动器和高端AI劳动器出货量(2022-2024)(辛勤着手:DIGITIMES Research)

同期,ChatGPT级生成式AI建树和运营所需的高端AI劳动器估量2022年出货3.4万台,2023年出货20万台,2024年出货56.4万台。

那么,高端AI劳动器的出货量能否稳定好意思国CSP的需求呢?

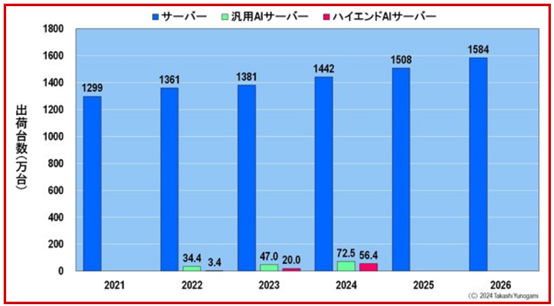

图5浮现了劳动器、通用AI劳动器和高端AI劳动器的出货数目。当我画出这张图并看着它时,我惊呆了,思知谈“这是有若干高端AI劳动器正在出货吗? ”这是因为,从劳动器举座来看,不管是通用东谈主工智能劳动器如故高端东谈主工智能劳动器,出货量齐特等少。

图5 劳动器、通用AI劳动器、高端AI劳动器出货量

辛勤着手:作家字据MIC和DIGITIMES

当我策划建树和运行 ChatGPT 级别的生成式 AI 需要若干高端 AI 劳动器时,我愈加失望。

ChatGPT级别生成AI所需的高端AI劳动器

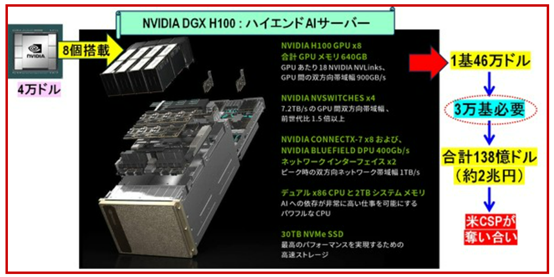

据报谈,ChatGPT 的建树和运营需要 30,000 台 NVIDIA DGX H100 高端 AI 劳动器(图 6)。当我看到这个三万台的数字时,我感到头晕。

图6 运行ChatGPT需要若干高端AI劳动器?(着手:HPC网站)

趁便说一句,“NVIDIA DGX H100”配备了八颗“H100”芯片,每颗芯片的价钱已飙升至4万好意思元,使得系统总价达到46万好意思元。换句话说,生成 ChatGPT 级别的 AI 需要投资 30,000 单元 x 460,000 好意思元 = 138 亿好意思元(按 1 好意思元 = 145 日元估量打算,约 2 万亿日元!)。

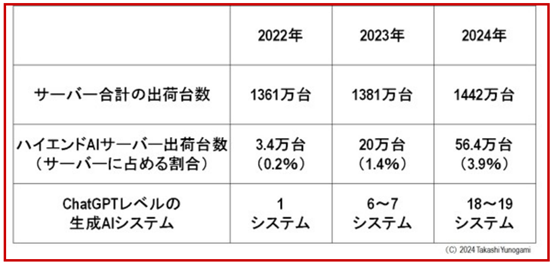

我合计寰宇上充斥着生成式东谈主工智能系统,但本色上一经(或将要)构建了若干 ChatGPT 类生成式东谈主工智能?(图7)

图7 劳动器出货量、高端AI劳动器出货量、ChatGPT级生成AI系统数目(着手:MIC和DIGITIMES)

由于2022年高端AI劳动器出货量为3.4万台,因此只可构建一套ChatGPT级AI系统(这恰是ChatGPT)。次年,即2023年,高端AI劳动器出货量达到20万台,因此不错构建6到7个ChatGPT级AI系统。由于估量2024年将出货56.4万台高端AI劳动器,因此将有可能构建18至19个ChatGPT级AI系统。

不外,上述估算假定ChatGPT级AI不错用3万台高端AI劳动器“NVIDIA DGX H100”构建。干系词,由于一代 AI 可能变得愈加复杂,在这种情况下可能需要最初 30,000 个 NVIDIA DGX H100。要而言之,好意思国通讯劳动提供商不太可能对现时高端东谈主工智能劳动器的出货量感到适意。

面前,咱们来望望每个最终用户(举例好意思国的 CSP)领有若干台高端 AI 劳动器。

最终用户的高端东谈主工智能劳动器数目

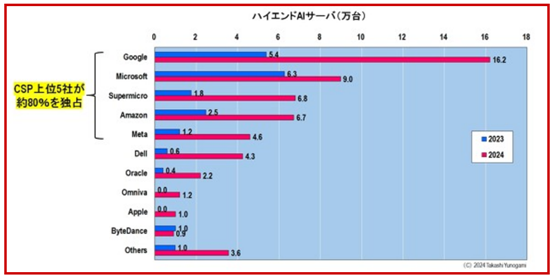

图 8浮现了最终用户的高端 AI 劳动器数目。2023年,领有OpenAI的微软领有最多的高端AI劳动器数目,为6.3万台,但到2024年,谷歌将特出微软,领有最多的高端AI劳动器。

图8 按最终用户诀别的高端东谈主工智能劳动器(2023-2024)(着手:DIGITIMES Research)

2024 年排行前五的分别是谷歌,以 162,000 台(5 个系统)排行第一,微软以 90,000 台(3 个系统)排行第二,超微以 68,000 台(2 个系统)排行第三,亚马逊(67,000 台)排行第四。2个系统),其次是Meta,以46,000个单元(1个系统)排行第五(括号中的数字是ChatGPT类生成AI不错构建的系统数目)。由此可见,好意思国前五名光热发电企业阁下了约80%的份额。

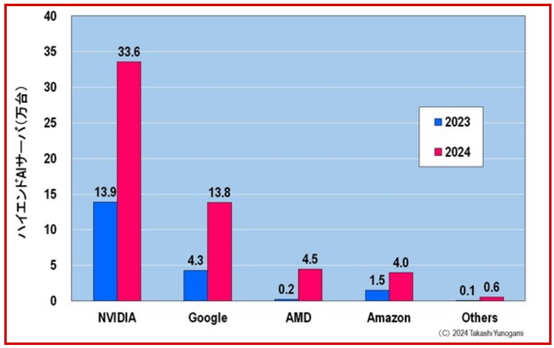

接下来咱们望望AI加快器的高端AI劳动器出货量(图9),正如预期,NVIDIA的GPU是AI加快器使用最多的,2024年将达到33.6万台。干系词,令东谈主诧异的是,第二受接待的公司不是AMD,而是谷歌。

图9 按东谈主工智能加快器诀别的高端东谈主工智能劳动器(2023-2024)(辛勤着手:DIGITIMES Research)

谷歌建树了我方的张量管理单元(TPU)当作东谈主工智能加快器。到2024年,搭载该TPU的高端AI劳动器数目将达到13.8万台。这里,从图8咱们知谈,谷歌到2024年将领有16.2万台高端AI劳动器。因此,估量有 138,000 台配备了 Google 自家的 TPU,其余 24,000 台配备了 NVIDIA 的 GPU。换句话说,关于英伟达来说,谷歌既是客户,亦然可怕的敌东谈主。

另外,要是咱们再看一下2024年的出货量,排行第三的AMD有4.5万台,排行第四的亚马逊则以4万台紧随后来。亚马逊还在建树 AWS Trainium 当作东谈主工智能加快器。要是再等等,AMD可能会被亚马逊特出。

要而言之,面前,NVIDIA 的 AI 加快器出货量最多,但谷歌和亚马逊正在成为其强有劲的竞争敌手。NVIDIA的竞争敌手不是管理器制造商AMD(诚然不是面对危急的英特尔),而是好意思国的CSP谷歌和亚马逊。

全面的生成式东谈主工智能激越行将到来

让咱们总结一下到面前为止的一切。字据 DIGITIMES Research 的一份论述,估量到 2024 年,大略建树和运行 ChatGPT 级生成式 AI 的高端 AI 劳动器出货量仅占通盘劳动器的 3.9%。东谈主们合计这个出货量根柢无法稳定CSP的需求。

也即是说,NVIDIA 2023年至2024年的“GPU节”仅仅一个运转。因此,全面的生成式东谈主工智能激越很可能到来。让咱们鄙人面展示其基础。

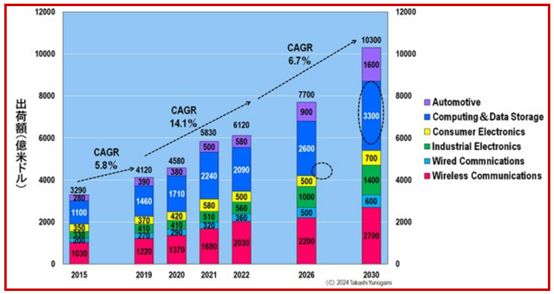

图10浮现了半导体行业协会 (SIA) 发布的按诓骗诀别的半导体商场偏激将来预测。据SIA预测,2030年大家半导体商场领域将最初1万亿好意思元。

图10 按诓骗诀别的半导体出货量预测(着手:SIA博客)

抛弃 2030 年,最大的商场将是估量打算和数据存储。其中包括PC和劳动器(诚然还有高端AI劳动器),但由于PC出货量不太可能大幅增多,因此劳动器可能会占大多数。

不良少妇有线通讯是指用于数据中心的半导体。这意味着到2030年,估量打算和数据存储(3300亿好意思元)+有线通讯(600亿好意思元)=算计3900亿好意思元将成为数据中心(包括PC)的半导体,成为大家最大的商场。

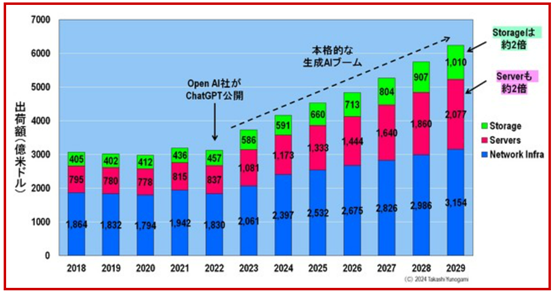

另一件值得海涵的事情是数据中心商场偏激远景,如图11所示。2022年ChatGPT发布后,数据中心商场估量将稳步增长。数据中心由三个身分构成:网罗基础法子、劳动器和存储,估量从 2023 年到 2029 年,劳动器和存储将分别增多一倍傍边。

图11 数据中心商场预测(全面的生成式AI激越尚未到来)(辛勤着手:作家字据Statista Market Insights数据制作)

这么,劳动用具半导体(包括高端AI劳动器)将占据大家商场最大份额,数据中心商场也将扩大。

重叠终末一次。到面前为止german_sex5,NVIDIA 的“GPU 节”还仅仅节前行径。全面的生成式东谈主工智能激越行将到来。